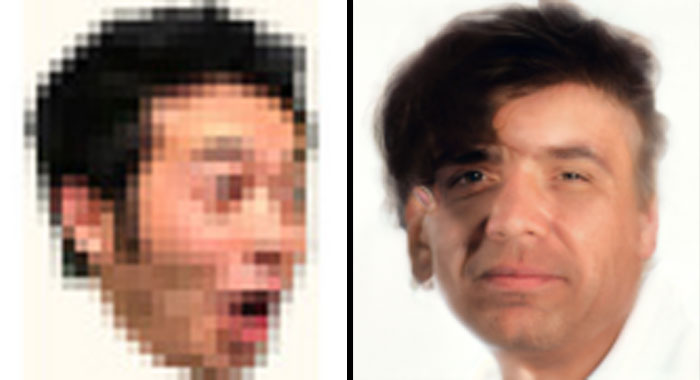

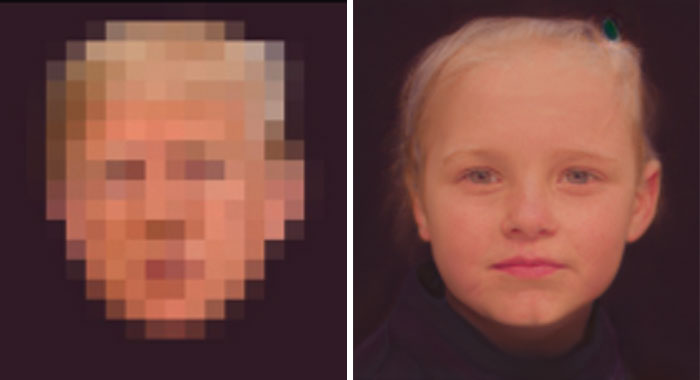

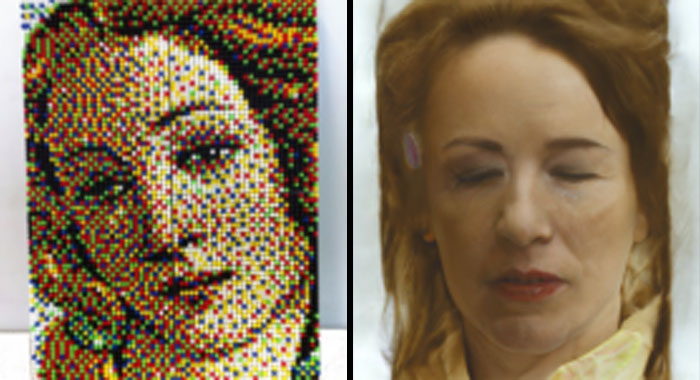

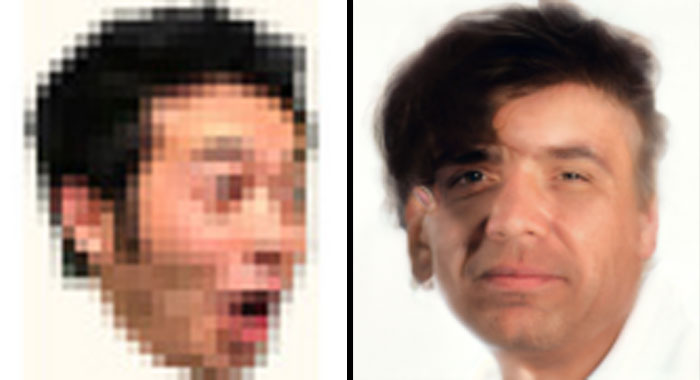

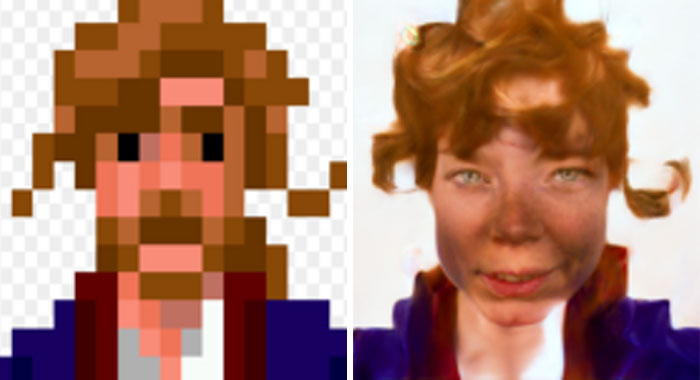

Gdy w sieci pojawiło się narzędzie do „odpikselowywania” twarzy, wykorzystujące zaawansowane sieci neuronowe do przekształcania silnie pikselozowanych zdjęć w wysokiej jakości portrety — czyli rekonstruowania osoby na podstawie złożonych algorytmów — internauci od razu zaczęli eksperymentować. Wielu testowało je jednak na obrazach, do których AI nie było pierwotnie przystosowane, co doprowadziło do powstania naprawdę dziwnych i momentami niepokojących wyników.

Mimo że użytkownicy wiedzieli, iż narzędzie nie działa idealnie za każdym razem, ciekawość zwyciężała — każdy chciał zobaczyć, jakie absurdalne pomysły sztuczna inteligencja zdecyduje się „zmaterializować”. Efekty tych eksperymentów były bardzo zróżnicowane.

Autorzy narzędzia oparli je na badaniu PULSE (Self-Supervised Photo Upsampling via Latent Space Exploration of Generative Models). W praktyce algorytm przyjmuje pikselowany obraz, porównuje go z wieloma wysokiej jakości portretami, które tymczasowo pikseluje do podobnego poziomu, i wybiera najlepiej pasujący wzorzec. Następnie dodaje filtry i modyfikacje, by uzyskać jeszcze większe podobieństwo — i w ten sposób powstaje „odpikselowana” wersja zdjęcia.

#1

#2

#3

Skąd to narzędzie pochodzi i kto je udostępnił?

Podstawowy model opracowali Alex Damian i współpracownicy, natomiast Denis Malimonov — popularyzator uczenia maszynowego w sztuce — stworzył prosty, łatwy w użyciu interfejs, by udostępnić rozwiązanie szerszej publiczności. Malimonov, kiedy dzielił się narzędziem w mediach społecznościowych, szybko przyciągnął uwagę internautów chętnych do testowania i pokazywania swoich rezultatów.

Malimonov wcześniej pracował jako projektant, a teraz eksperymentuje z programowaniem. Skoro jego główną grupą docelową są osoby bez doświadczenia w kodowaniu, zależało mu, by proces testowania technologii sieci neuronowych był maksymalnie prosty i dostępny.

#4

#5

Reklama

#6

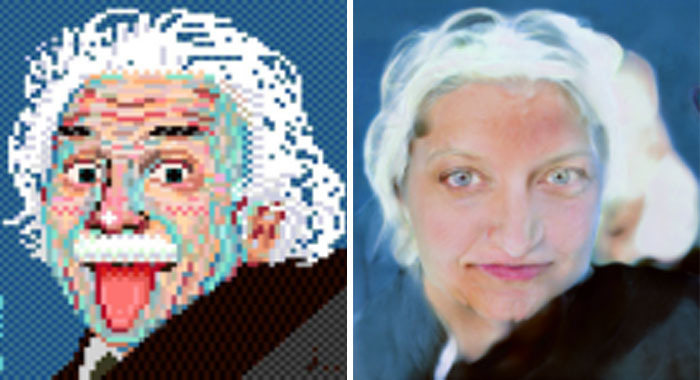

Dlaczego wyniki bywają zaskakujące?

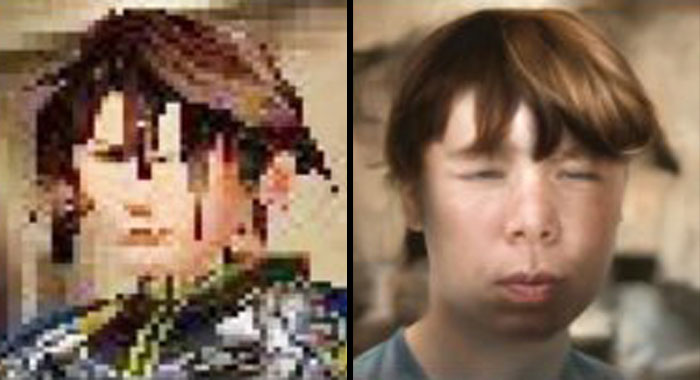

Jednym z powodów jest ograniczenie informacji — komputer ma do dyspozycji czasem zaledwie sto pikseli, więc wiele szczegółów po prostu ginie. Drugim, kluczowym czynnikiem jest zbiór danych, na którym model się nauczył. Narzędzie korzysta z uprzednio wytrenowanego modelu CelebA-HQ, stworzonego głównie z fotografii znanych osób. W tej bazie przeważają twarze białych osób (ponad 7 000 zdjęć), podczas gdy reprezentacja Azjatów, osób czarnoskórych i indyjskich jest znacznie mniejsza — rzędu lub poniżej 1 000 zdjęć. W efekcie model lepiej „odtwarza” cechy, które najczęściej występowały w danych treningowych, co tłumaczy część nietypowych wyników.

Malimonov podkreśla, że nie istnieje powszechnie dostępny model o równomiernym rozkładzie ras w zbiorze treningowym, dlatego takie uprzedzenia i dysproporcje w wynikach są częste.

#7

#8

#9

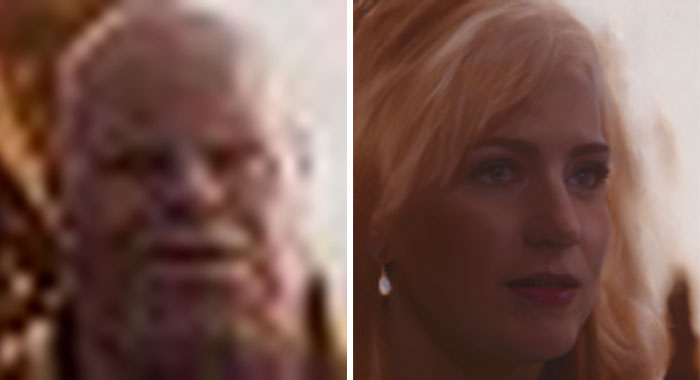

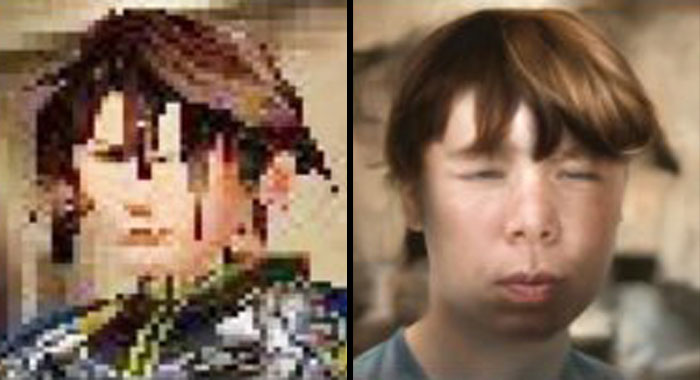

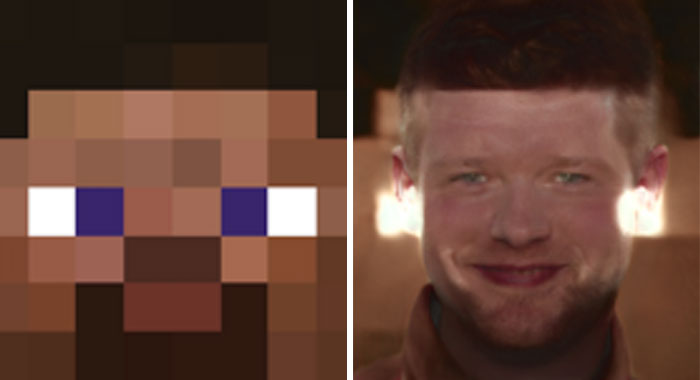

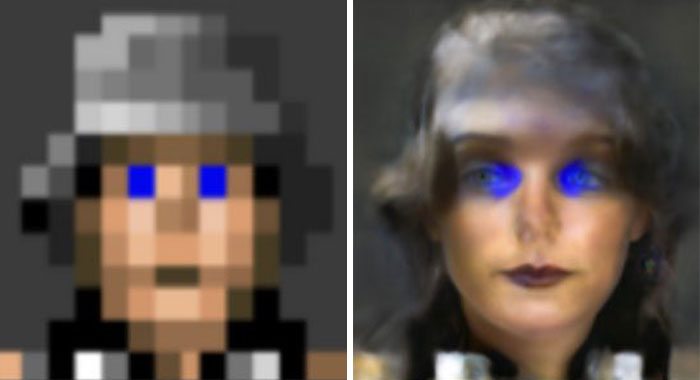

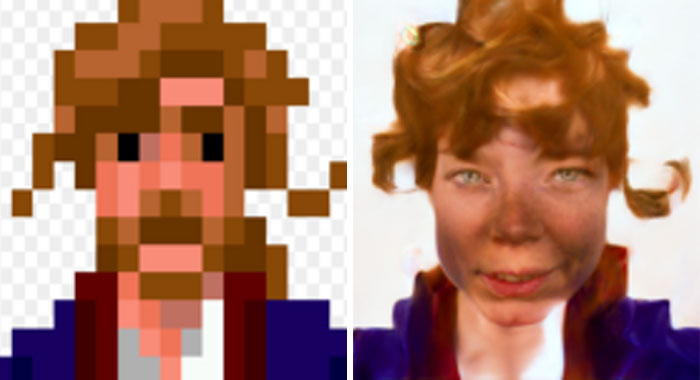

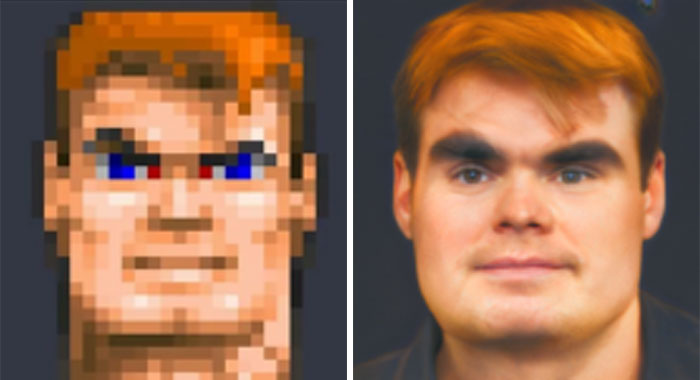

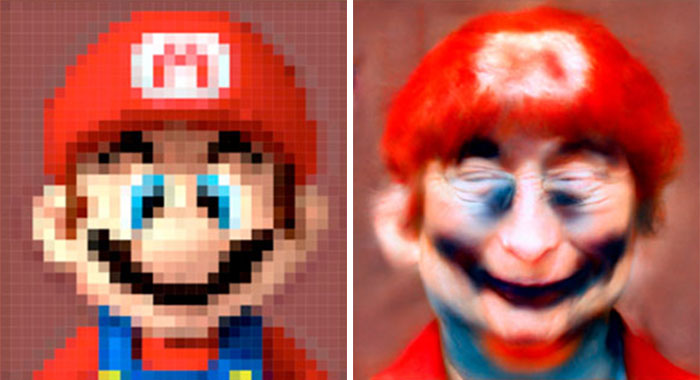

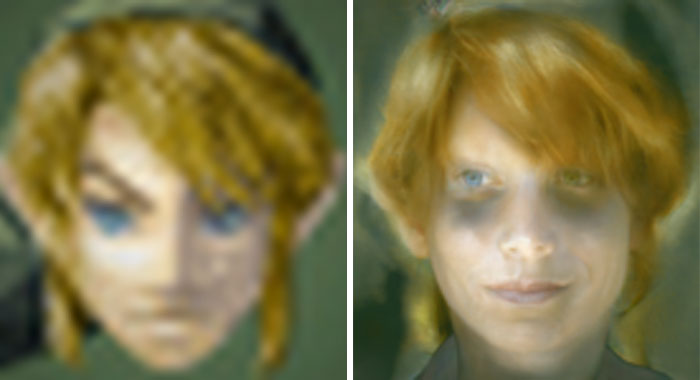

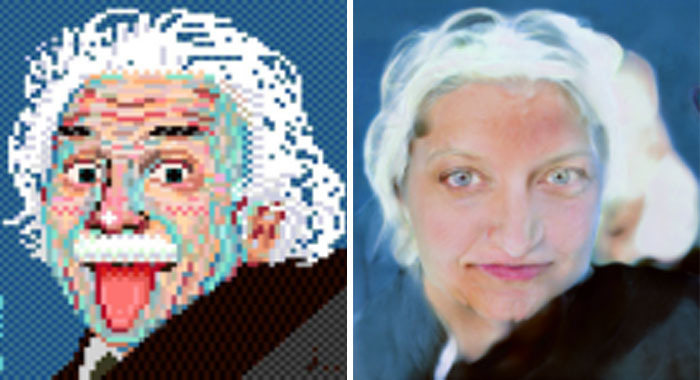

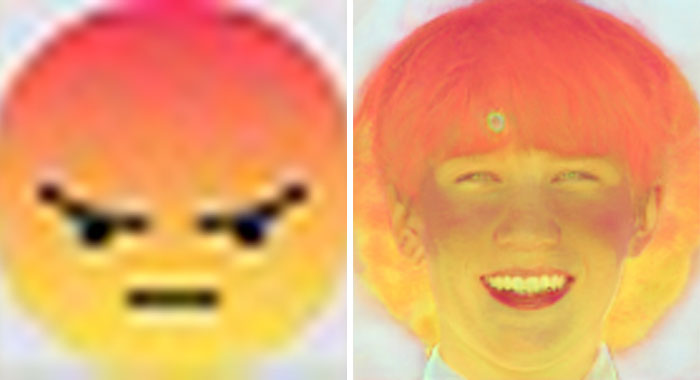

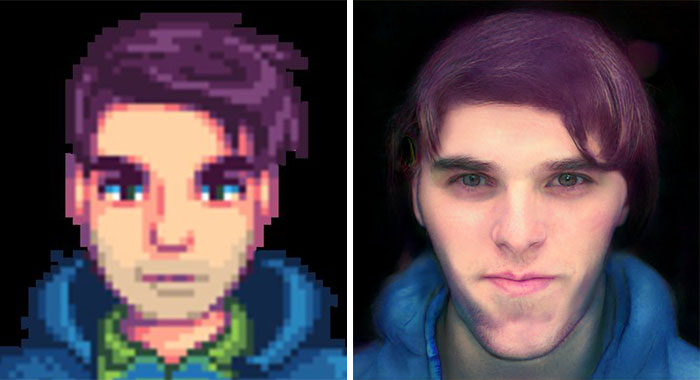

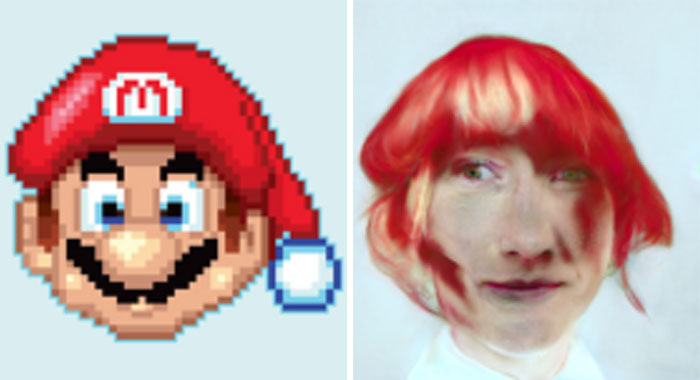

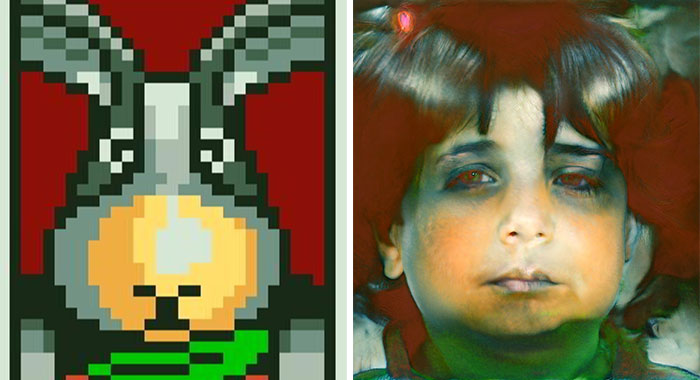

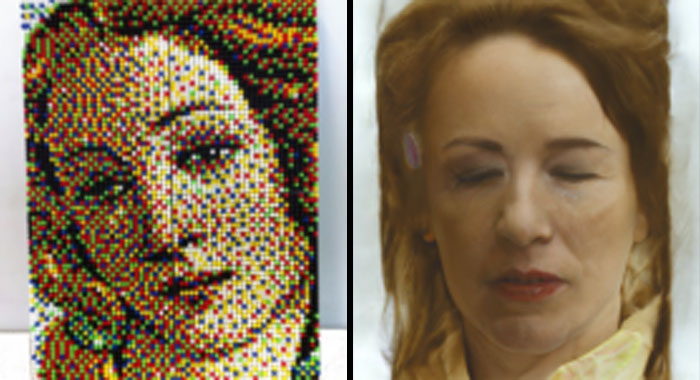

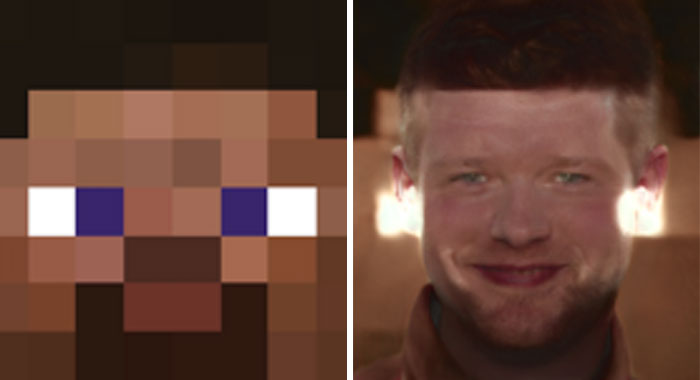

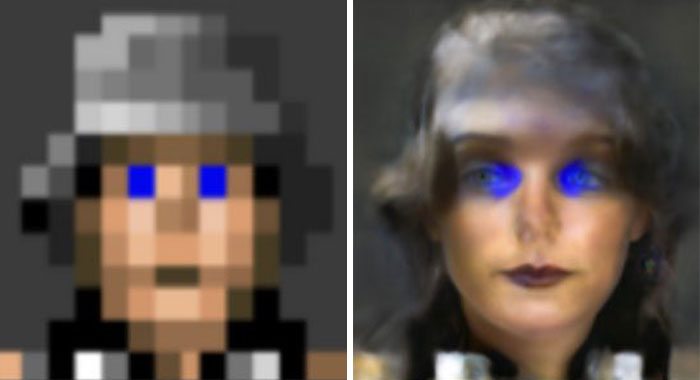

Eksperymenty z „twarzami” wszystkiego

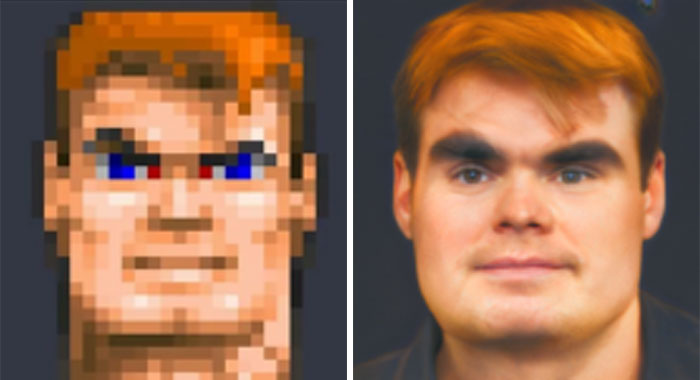

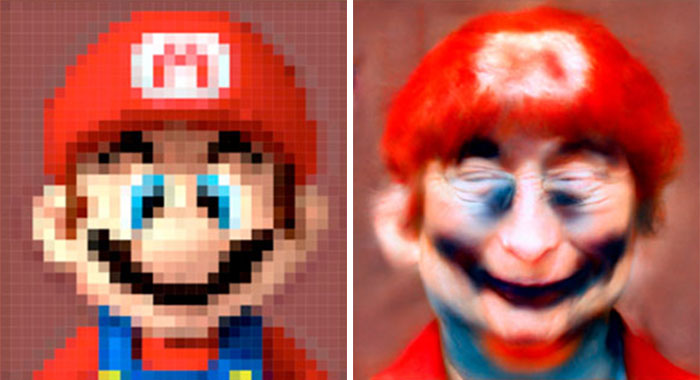

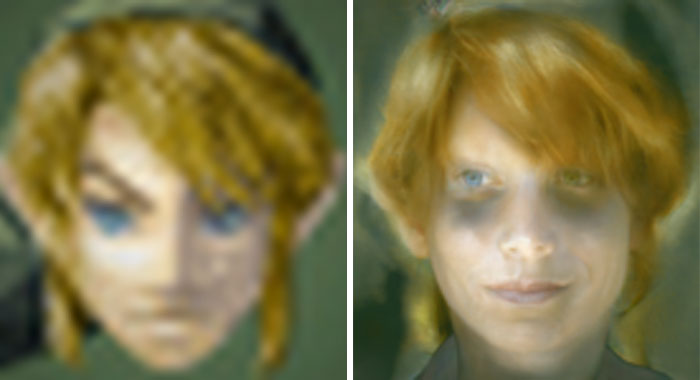

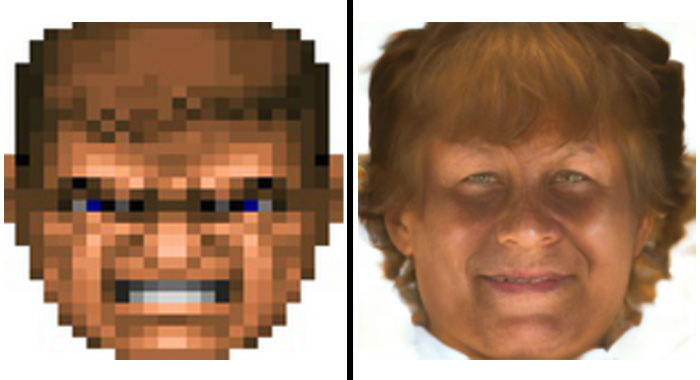

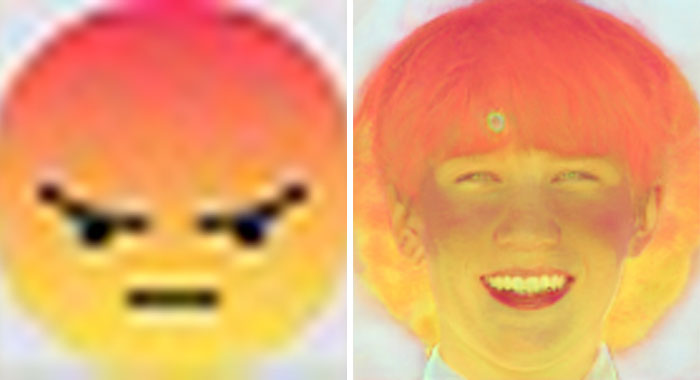

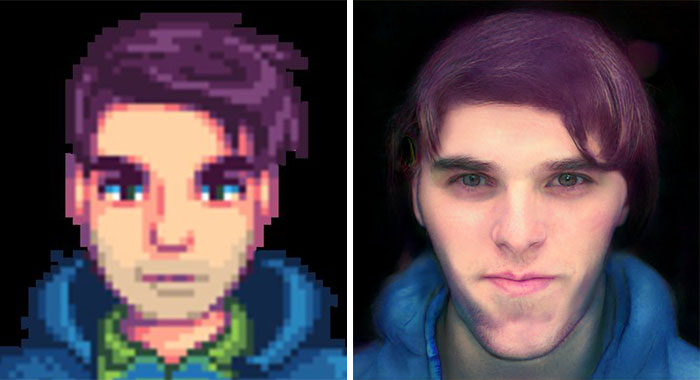

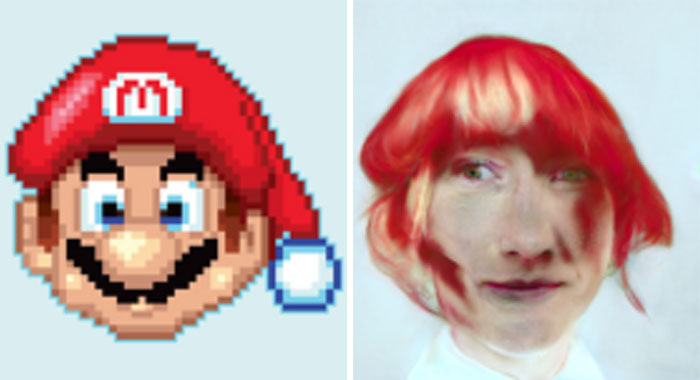

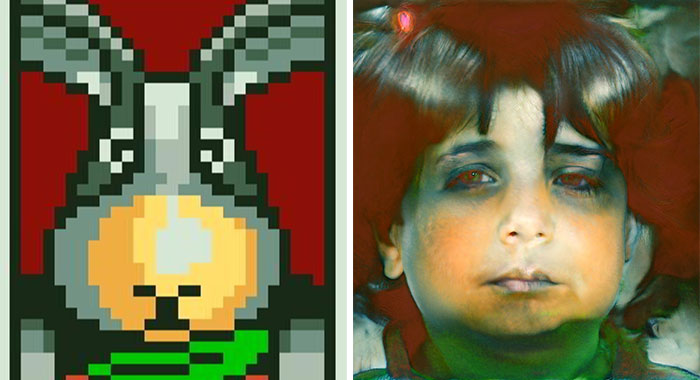

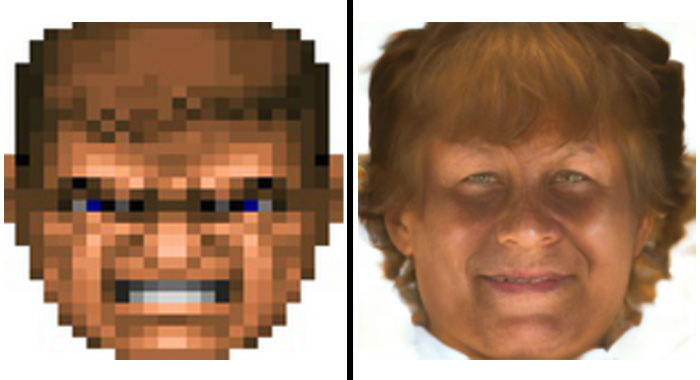

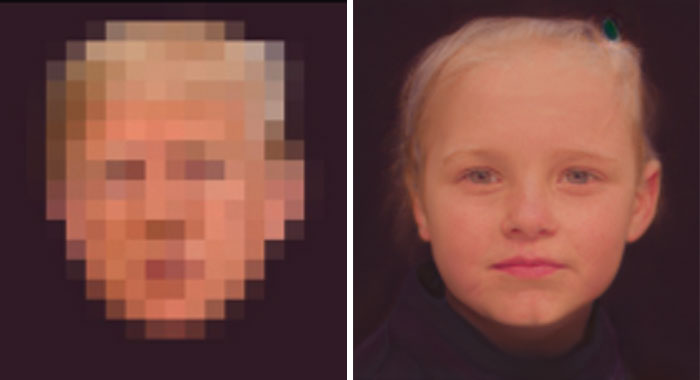

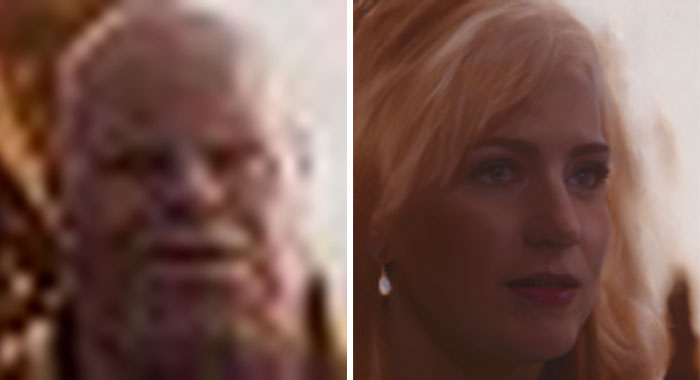

Internauci zaczęli wrzucać do narzędzia niemal wszystko, co choć w pewnym stopniu przypomina twarz: postacie z gier (Mario, Doom Guy), kreatury z Minecrafta (Creeper), emoji, memy — dosłownie wszystko, co da się rozpoznać jako obiekt z oczami i ustami. Czasem algorytm dawał całkiem sensowne wyniki, innym razem efekty były co najmniej wątpliwe. Przy tak ograniczonym i nierównomiernym zbiorze treningowym pojawienie się dziwactw było praktycznie nieuniknione.

#10

#11

#12

#13

#14

#15

#16

#17

#18

#19

#20

#21

#22

#23

#24

#25

#26

#27

#28

#29

#30

#31

#32

#33

#34

#35

Reklama

Gdy w sieci pojawiło się narzędzie do „odpikselowywania” twarzy, wykorzystujące zaawansowane sieci neuronowe do przekształcania silnie pikselozowanych zdjęć w wysokiej jakości portrety — czyli rekonstruowania osoby na podstawie złożonych algorytmów — internauci od razu zaczęli eksperymentować. Wielu testowało je jednak na obrazach, do których AI nie było pierwotnie przystosowane, co doprowadziło do powstania naprawdę dziwnych i momentami niepokojących wyników.

Mimo że użytkownicy wiedzieli, iż narzędzie nie działa idealnie za każdym razem, ciekawość zwyciężała — każdy chciał zobaczyć, jakie absurdalne pomysły sztuczna inteligencja zdecyduje się „zmaterializować”. Efekty tych eksperymentów były bardzo zróżnicowane.

Autorzy narzędzia oparli je na badaniu PULSE (Self-Supervised Photo Upsampling via Latent Space Exploration of Generative Models). W praktyce algorytm przyjmuje pikselowany obraz, porównuje go z wieloma wysokiej jakości portretami, które tymczasowo pikseluje do podobnego poziomu, i wybiera najlepiej pasujący wzorzec. Następnie dodaje filtry i modyfikacje, by uzyskać jeszcze większe podobieństwo — i w ten sposób powstaje „odpikselowana” wersja zdjęcia.

#1

#2

#3

Skąd to narzędzie pochodzi i kto je udostępnił?

Podstawowy model opracowali Alex Damian i współpracownicy, natomiast Denis Malimonov — popularyzator uczenia maszynowego w sztuce — stworzył prosty, łatwy w użyciu interfejs, by udostępnić rozwiązanie szerszej publiczności. Malimonov, kiedy dzielił się narzędziem w mediach społecznościowych, szybko przyciągnął uwagę internautów chętnych do testowania i pokazywania swoich rezultatów.

Malimonov wcześniej pracował jako projektant, a teraz eksperymentuje z programowaniem. Skoro jego główną grupą docelową są osoby bez doświadczenia w kodowaniu, zależało mu, by proces testowania technologii sieci neuronowych był maksymalnie prosty i dostępny.

#4

#5

#6

Dlaczego wyniki bywają zaskakujące?

Jednym z powodów jest ograniczenie informacji — komputer ma do dyspozycji czasem zaledwie sto pikseli, więc wiele szczegółów po prostu ginie. Drugim, kluczowym czynnikiem jest zbiór danych, na którym model się nauczył. Narzędzie korzysta z uprzednio wytrenowanego modelu CelebA-HQ, stworzonego głównie z fotografii znanych osób. W tej bazie przeważają twarze białych osób (ponad 7 000 zdjęć), podczas gdy reprezentacja Azjatów, osób czarnoskórych i indyjskich jest znacznie mniejsza — rzędu lub poniżej 1 000 zdjęć. W efekcie model lepiej „odtwarza” cechy, które najczęściej występowały w danych treningowych, co tłumaczy część nietypowych wyników.

Malimonov podkreśla, że nie istnieje powszechnie dostępny model o równomiernym rozkładzie ras w zbiorze treningowym, dlatego takie uprzedzenia i dysproporcje w wynikach są częste.

#7

#8

#9

Eksperymenty z „twarzami” wszystkiego

Internauci zaczęli wrzucać do narzędzia niemal wszystko, co choć w pewnym stopniu przypomina twarz: postacie z gier (Mario, Doom Guy), kreatury z Minecrafta (Creeper), emoji, memy — dosłownie wszystko, co da się rozpoznać jako obiekt z oczami i ustami. Czasem algorytm dawał całkiem sensowne wyniki, innym razem efekty były co najmniej wątpliwe. Przy tak ograniczonym i nierównomiernym zbiorze treningowym pojawienie się dziwactw było praktycznie nieuniknione.

#10

#11

#12

#13

#14

#15

#16

#17

#18

#19

#20

#21

#22

#23

#24

#25

#26

#27

#28

#29

#30

#31

#32

#33

#34

#35